El 29 de enero, Wiz Research con sede en Estados Unidos anunció que reveló responsablemente una base de datos de Deepseek anteriormente abierta al público, exponiendo registros de chat y otra información confidencial. Deepseek bloqueó la base de datos, pero el descubrimiento destaca los posibles riesgos con modelos de IA generativos, particularmente proyectos internacionales.

Deepseek sacudió la industria tecnológica durante la última semana como la Los modelos de IA de la compañía china rivalizaron a los líderes de IA generativos estadounidenses. En particular, el R1 de Deepseek compite con OpenAI O1 en algunos puntos de referencia.

¿Cómo descubrió Wiz Research la base de datos pública de Deepseek?

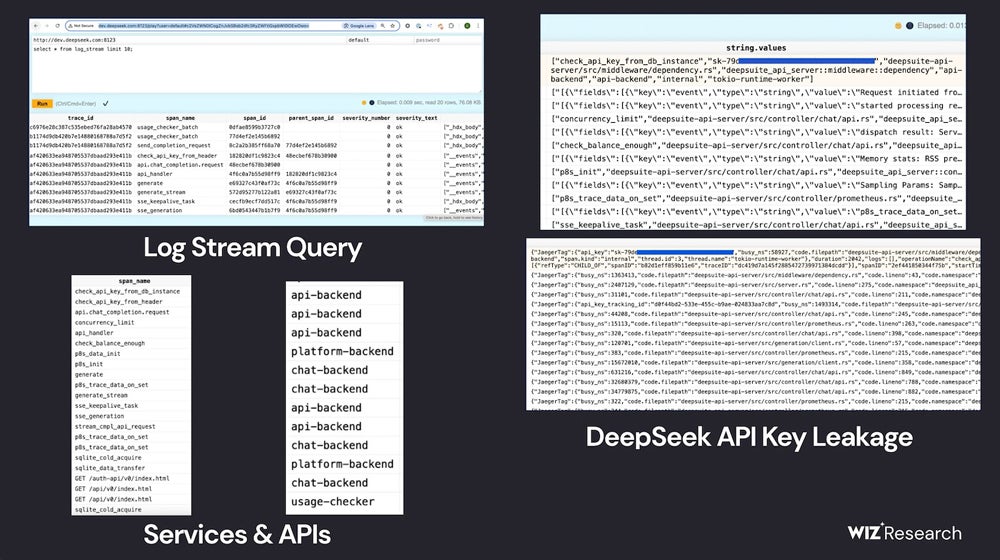

En una publicación de blog que revela el trabajo de Wiz Research, el investigador de seguridad de la nube Gal Nagli detalló cómo el equipo encontró un base de datos de clickhouse de acceso público que pertenece a Deepseek. La base de datos abrió posibles rutas para el control de la base de datos y los ataques de escalada de privilegios. Dentro de la base de datos, Wiz Research podría leer el historial de chat, los datos del backend, los transmisiones de registros, los secretos de API y los detalles operativos.

El equipo encontró la base de datos de Clickhouse “en cuestión de minutos” mientras evaluaban las posibles vulnerabilidades de Deepseek.

“Nos sorprendió y también sentimos una gran sensación de urgencia de actuar rápido, dada la magnitud del descubrimiento”, dijo Nagli en un correo electrónico a TechRepublic.

Primero evaluaron los subdominios orientados a Internet de Deepseek, y dos puertos abiertos los consideraron inusuales; Esos puertos conducen a la base de datos de Deepseek alojada en Clickhouse, el sistema de administración de bases de datos de código abierto. Al navegar por las tablas en Clickhouse, Wiz Research encontró el historial de chat, las teclas API, los metadatos operativos y más.

El Equipo de Investigación de Wiz señaló que no “ejecutó consultas intrusivas” durante el proceso de exploración, según las prácticas de investigación ética.

¿Qué significa la base de datos disponible públicamente para la IA de Deepseek?

Wiz Research informó a Deepseek de la violación y la compañía AI bloqueó la base de datos; Por lo tanto, los productos de Deepseek AI no deben verse afectados.

Sin embargo, la posibilidad de que la base de datos haya permanecido abierta a los atacantes resalte la complejidad de asegurar IA generativa productos.

“Si bien gran parte de la atención sobre la seguridad de la IA se centra en las amenazas futuristas, los peligros reales a menudo provienen de riesgos básicos, como la exposición externa accidental de las bases de datos”, escribió Nagli en una publicación de blog.

Los profesionales de TI deben ser conscientes de los peligros de adoptar productos nuevos y no probados, especialmente la IA generativa, demasiado rápido: dar tiempo a los investigadores para encontrar errores y defectos en los sistemas. Si es posible, incluya plazos cautrosos en la empresa Políticas generativas de uso de IA.

VER: Proteger y asegurar datos se ha vuelto más complicado en los días de IA generativa.

“A medida que las organizaciones se apresuran a adoptar herramientas y servicios de IA de un número creciente de startups y proveedores, es esencial recordar que al hacerlo, estamos confiando a estas empresas datos confidenciales”, dijo Nagli.

Dependiendo de su ubicación, es posible que los miembros del equipo de TI deban ser conscientes de las regulaciones o las preocupaciones de seguridad que pueden aplicarse a los modelos de IA generativos que se originan en China.

“Por ejemplo, ciertos hechos en la historia o el pasado de China no son presentados por los modelos de manera transparente o completa”, señaló Unmesh Kulkarni, Jefe de Gen AI de la firma de ciencia de datos Tredence, en un correo electrónico a TechRepublic. “Las implicaciones de privacidad de datos de llamar al modelo alojado tampoco están claras y la mayoría de las empresas globales no estarían dispuestas a hacerlo. Sin embargo, uno debe recordar que los modelos Deepseek son de código abierto y se pueden implementar localmente dentro del entorno privado de red o red de una empresa. Esto abordaría los problemas de privacidad de datos o las preocupaciones de fuga “.

Nagli también recomendó modelos autohospedados cuando TechRepublic lo alcanzó por correo electrónico.

“Implementar controles de acceso estrictos, cifrado de datos y segmentación de red puede mitigar aún más los riesgos”, escribió. “Las organizaciones deben asegurarse de que tengan visibilidad y gobernanza de toda la pila de IA para que puedan analizar todos los riesgos, incluido el uso de modelos maliciosos, la exposición de datos de capacitación, datos confidenciales en capacitación, vulnerabilidades en SDK de IA, exposición de servicios de IA y otros tóxicos Combinaciones de riesgos que pueden explotarse por los atacantes “.